دیپ فیک

دیپ فیک چیست؟

دیپ فیک فناوری جدیدی بر مبنای هوش مصنوعی است که به واسطه آن تصاویر و ویدیو های دروغین اما واقع گرایانه درست میشود و میتواند هر بینندهای را تحت تاثیر خود قرار دهد. امروزه ویدیو های دیپ فیک بسیاری از هنرمندان و افراد مشهور ساخته میشود و بیننده بدون آنکه متوجه عدم صحت و واقعیت آنها شود، محتوای آن ها را باور کرده و به انتشار آنها در فضای مجازی دست میزند. در نتیجه با توجه به پیشروی بدون محدودیت این فناوری، باید گفت که به زودی تشخیص بین مرز حقیقت و دروغ کاملا غیر ممکن میشود.

دیپ فیک نام یک تکنیک نرمافزاری مبتنی بر هوش مصنوعی است که در محتوای صوتی و تصویری دست میبرد و آن را به شکل دلخواه تغییر میدهد و در نهایت محتوایی به دست میآید که کاملاً متفاوت از حقیقت است. دیپ فیک، ترکیب دو کلمه یادگیری عمیق(Deep Learning) و جعل(Fake) است که به خوبی عملکرد این تکنیک را تشریح میکند.

در واقع فناوری دیپ فیک برای ایجاد محتوای صوتی و تصویری متقاعدکننده و درعینحال غیرواقعی ساخته شده؛ یک فناوری که بهسرعت در حال رشد و بهبود است و انتظار میرود روزبهروز استفاده از آن گستردهتر شود. برنامههای ویرایش تصویر نظیر فتوشاپ، سالها کاری مشابه را از طریق جعل کردن تصاویر انجام میدادند؛ اما چیزی که اکنون با آن روبهرو هستیم، مبحثی کاملاً متفاوت و نگرانکنندهتر از جعل عکس یک نفر در فتوشاپ است.

در دیپ فیک تلفیق تصاویر و فیلمهای موجود با منبع مورد نظر ویدئویی به نحوی صورت میگیرد که گویی ترکیب هر دو تصویر یا هر دو فیلم یکی است و در یک صحنه رخ میدهد. این ترکیب پیچیده به عنوان مثال میتواند فرد یا افراد مختلف را به گفتن جملات و یا در حال انجام کارهایی نشان دهد که هرگز در واقعیت رخ ندادهاند. فیلمهای تولید شده از تکنیک دیپ فیک میتواند بدین شکل ایجاد گردند که حضور شخصی را در فیلمهای غیراخلاقی نمایش دهند به طوری که هرگز فرد در آن فیلم حضور نداشته است. این ویدئوها حتی میتوانند تصویر فرد را در رویدادهای سیاسی و مجرمانه از جمله صحنههای قتل، سرقت و غیره قرار دهند. پیشتر، کمتر کسی فکر میکرد که روزی بتوان محتوای یک ویدئو را بهطور کلی و بدون دخالت مستقیم انسان تغییر داد؛ اما اکنون دیپ فیک ثابت کرده که چنین باوری در دنیای امروز جایی ندارد و بهراحتی میتوان ویدئوهایی تولید کرد که به سبب واقعگرایانه بودن، نتوان میان حقیقت یا دروغ بودن آنها تمایزی قائل شد.

اما هولناکترین بخش دیپ فیک در این آنجا است که امروزه قربانیان این تکنیک نه تنها شامل سلبریتیها میشود بلکه سیاستمداران را نیز مورد هدف قرار داده است. این میتواند به معنای فریب طیف گستردهای از مردم در شبکههای اجتماعی و گسترش عمیق پروپاگاندا در میان افراد جامعه تلقی شود. این مسئله وقتی وجههی ترسناکتری به خود میگیرد که متوجه میشویم نرمافزارهای دیپ فیک نه تنها به راحتی قابل دسترسی است، بلکه هر روز تشخیص تصاویر و ویدئوهای این تکنیک دشوار و دشوارتر میشود.

اصولاً نرمافزارهای دیپ فیک به منظور تخریب هویت فرد بکار میروند، این سناریوی کابوسواری است نه فقط برای از بین بردن زندگی شخصی شما، بلکه برای دستکاری ادراک عمومی در سران کشورها، مدیران ارشد یا نامزدهای سیاسی میتواند مورد استفاده قرار گیرد. دیپ فیک میتواند آینده یک کشور را از نظر سیاسی تحت تأثیر قرار دهد و این اتفاق، میزان خطرناکی تکنیک جعل تصویر را نشان میدهد. افراد میتوانند با استفاده از این تکنولوژی از شخصیتهای سیاسی در جهت خواست خود استفاده کرده و حرفها و سخنهای زیادی را به مخاطبین خود انتقال دهند. در این صورت تشخیص راست و دروغ برای بیننده و شنونده مشکل خواهد بود و او میتواند این ویدئوها را واقعی تلقی کرده و در نتیجه بر مبنای آن برای آینده سیاسی کشورشان تصمیمگیری کند.

دیپ فیک چگونه کار می کند؟

ویدیو دیپ فیک توسط دو سیستم هوش مصنوعی رقیب ایجاد میشود که یکی تولیدکننده و دیگری تفکیک کننده نام دارد. اساساً، تولید کننده، ویدیویی جعلی میسازد و از تفکیک کننده میپرسد که آیا ویدیو واقعی است یا نه. هر بار که تفکیک کننده، ویدیویی را به درستی جعلی تشخیص دهد، به تولید کننده سرنخی میدهد درباره کاری که تولید کننده نباید هنگام ساخت ویدیو بعدی انجام دهد. با بهبود تولید کننده در تولید کلیپهای ویدیویی، تفکیک کننده نیز در شناسایی آنها بهتر میشود. برعکس، با بهبود تفکیک کننده در شناسایی ویدیوهای جعلی، تولید کننده در ساخت آنها بهتر میشود.

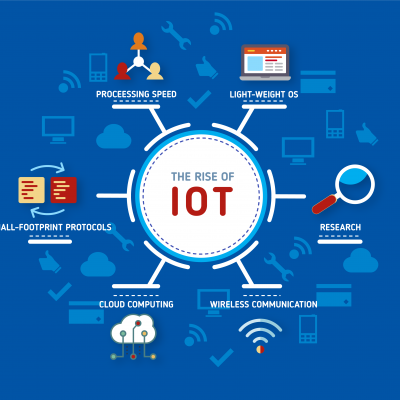

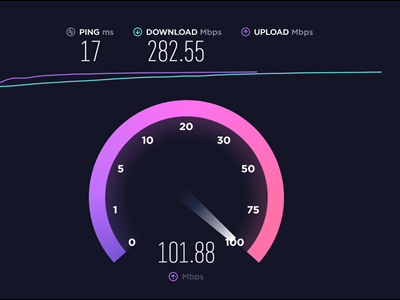

راههای مختلفی برای تولید دیپ فیک وجود دارد که پایه همه آنها این است که باید حجم عظیمی از داده به مدلهای یادگیری ماشین داده شود تا محتوای جعلی تولید گردد. واقعگرایانهترین نمونههای دیپ فیک حجم عظیمی از دادههای صوتی و تصویری را برای این کار مورد پردازش قرار دادهاند.

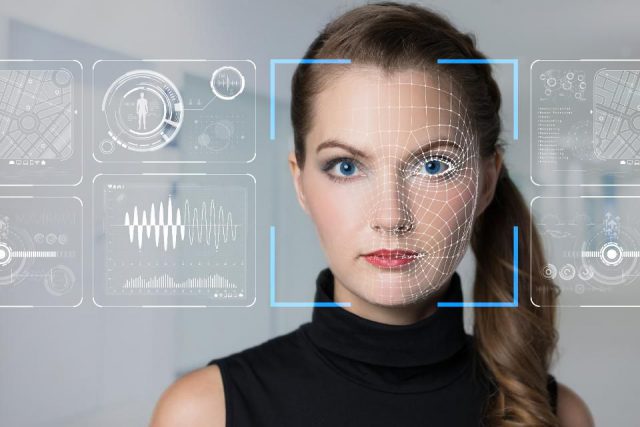

اما پیشرفتهترین روش ساخت ویدیوهای دیپ فیک ، استفاده از پایگاههای عظیم داده است. در این روش هوش مصنوعی عضوهای صورت مانند چشم، بینی و دهان، چهره فرد را به خوبی شناسایی و تجزیه تحلیل کرده و بازسازی میکند. در واقع هوش مصنوعی تمام قسمتهای متحرک صورت را اسکن کرده و حرکاتی مانند پلک زدن، حرکات دهان و… را زیر نظر میگیرد. بعد از اتمام این بررسی و تجزیه و تحلیلها توسط هوش مصنوعی، این دادهها ذخیره میشود و در نهایت با ارائه چند عکس از سوژه، ویدئو جعلی مورد نظر ساخته میشود.

دیپ فیک یا فناوری «جعل عمیق» چیست؟

فناوری دیپ فیک یا «جعل عمیق» در سال 2014 برای اولین بار توسط یک دانشجوی مقطع دکترا به نام «ایان گودفلو» اختراع شد. گفتنی است گودفلو در حال حاضر در شرکت اپل مشغول به کار است.

دیپ فیک از ترکیب دو واژه دیپ (Deep) به معنای عمیق و فیک (Fake) به معنای جعلی و دروغین تشکیل شده است و براساس هوش مصنوعی قادر است تصاویر انسان را به صورت واقع گرایانه تولید و سنتز کند. در فناوری دیپ فیک یا همان جعل عمیق، از دسته خاصی از الگوریتم یادگیری ماشین با نام «شبکههای مولد تخاصمی» یا «Generative Adversarial Networks» استفاده میشود تا تصاویر یا ویدیو های موجود روی مجموعهای از تصاویر و ویدیو های منبع، ترکیب و برهم نهی شود.

دیپ فیک مبتنی بر روش یادگیری عمیق است و از شبکه های مولد تخاصمی که به اختصار به آن ها شبکههای GAN گفته میشود، استفاده میکند. الگوریتم های GAN از دو مدل هوش مصنوعی تشکیل میشوند. در این سیستم وظیفه یکی از مدل ها تولید محتوا (تولید تصاویر افراد) و وظیفه مدل رقیب، تشخیص واقعی بودن و یا جعلی بودن عکس تولید شده است. گفتنی است در ابتدای کار مدل هوش مصنوعی رقیب قادر است به راحتی عکس جعلی را از عکس واقعی تشخیص دهد اما با گذشت زمان دقت و عملکرد مدل هوش مصنوعی تولید کننده به قدری افزایش مییابد که تشخیص جعلی بودن محتوای تولید شده برای مدل رقیب بسیار سخت میشود.

مزیت هوش مصنوعی این است که مانند انسان قابلیت یادگیری دارد و میتواند روز به روز بیشتر یاد گرفته و پیشرفت کند. در ساخت دیپ فیک در کنار هوش مصنوعی از شبکه عصبی نیز کمک گرفته میشود. در واقع هوش مصنوعی به تجزیه و تحلیل امور میپردازد و شبکه عصبی وظیفه یادگیری و بهبود را بر عهده دارد.

دیپ فیک تنها در مواردی که ذکر شد استفاده نمیشود و اپلیکیشنی مانند اسنپچت نیز برای اعمال فیلترهای مبتنیبر چهره از چنین فناوری بهره میبرد. همچنین اپلیکیشنی به نام FakeApp با استفاده از نرمافزارهای متنباز گوگل، به کاربران اجازه میدهد تا چهرهی خود را بهصورت واقعگرایانهای با دیگران جابهجا کنند؛ آن هم بدون اینکه دستکاری شدن ویدئو مشخص باشد. تا همین اواخر، تغییر محتوای ویدیویی به طرزی محسوسی بسیار سخت بود. اما ظهور اپلیکیشنهای این چنینی باعث شدهاند که حتی افرادی که در حد انجام کارهای روزمره با کامپیوتر آشنایی دارند، بتوانند بهراحتی شیوهی کارکرد دیپ فیک را یاد بگیرند و از آن برای اهداف خود استفاده کنند. متأسفانه، این بدان معناست که هرکسی میتواند یک ویدیوی دیپ فیک برای ترویج موضوع مورد نظر خود تولید و منتشر کند. یکی از خطرات مرتبط با دیپ فیک این است که افراد ممکن است این ویدیوها را باور کنند و خطر دیگر آنجایی است که شاید دیگر نتوان به اعتبار هیچ ویدئویی اعتماد کرد.

چرا فناوری دیپ فیک خطرناک است؟

فناوری دیپ فیک یا همان جعل عمیق در طول ظهور و پیدایش خود، نه تنها جامعه بازیگران و سلبریتی ها را هدف گرفته بلکه به حریم چهرههای بزرگ سیاستمدار نیز تجاوز کرده است. به عنوان مثال چندی پیش ویدیویی از باراک اوباما منتشر شد که در آن دونالد ترامپ را فردی حقیر و غیرمنطقی خطاب میکرد. اگرچه این ویدیو صحت نداشت و کاملا غیر واقعی بود اما افراد زیادی در ابتدا آن را باورد کردند و دست به انتشار آن در فضای مجازی کردند. در همین راستا رئیس جمهور سابق آمریکا، باراک اوباما، در خصوص تکنولوژی دیپ فیک اظهار نظر کرده و ابراز کرده است در دنیایی که میتوانند به سادگی صحبتها و ویدیوهای غیرواقعی از من ساخته و منتشر کنند، به مرحلهای خواهیم رسید که تشخیص مرز بین واقعیت و دروغ بسیار مشکل خواهد شد و این مطمئنا بر پایههای دموکراسی ما که بر مبنای حقیقت است، تاثیر خواهد گذاشت.

دیپ فیکها یکی از از دستاوردهای هوش مصنوعی هستند که میتوانند برای نمونه حرکات و چهره یک نفر را دستکاری کنند و حرفهای ناگفته توی دهانش بگذارند. این ویدیوهای جعلی که با بهرهگیری از Deep Learning (یادگیری ژرف) و حجم عظیمی از دادهها و شبکه عصبی مصنوعی ساخته میشوند، نتیجه محاسبات پیچیدهای هستند که برای نمونه میتوانند از دو ویدیو (دو منبع تصویری)، یک ویدیوی جعلی تازه خلق کنند. البته همانگونه که اشاره شد، این دستکاری تنها به ویدیو خلاصه نمیشود؛ با این تکنولوژی میتوان صداها را هم دستکاری کرد به گونهای که شخصی جملهای را بر زبان بیاورد که هیچگاه نگفته است.

دیپ فیک چگونه متولد شد؟

سال ۲۰۱۴ یان گودفلو، یکی از پژوهشگران نامدار عرصه یادگیری ژرف و هوش مصنوعی در آمریکا، سیستم شبکههای رقابتی مولد را که به اختصار GAN نام دارند، به دنیای تکنولوژی معرفی کرد؛ GANها از جمله میتوانستند به عنوان ابزاری مفید در سیستمهای هوش مصنوعی برای تولید عکسها و ویدیوهایی که حالا آنها را دیپ فیک مینامیم، به کار روند.

در این میان یکی از موضوعهایی که به ویژه به نگرانی سیاستمداران دامن زده، نزدیکشدن به انتخابات آمریکا و سوءاستفاده از دیپ فیک در فضای پیشاانتخاباتی این کشور است. سال ۲۰۱۶ آنچه که بر انتخابات ریاست جمهوری آمریکا سایه افکند، موضوع انتشار اطلاعات اشتباه، فیک نیوز، بود و ظن تلاش برای دستکاری اطلاعات. اکنون پیش از انتخابات ۲۰۲۰ آمریکا و در فضایی که هر جرقهای میتواند آتش دودستگی را در این کشور شعلهور کند، بیم و نگرانی از دیپ فیکها و نقش احتمالی آنها در انحراف افکار عمومی برجسته میشود.

تلاش برای مقابله با دیپفیکها از راه تشخیص اصل از جعل

نگرانی سیاستمداران جدی است، تا آنجا که دست به کار شدهاند. آژانس پروژههای پیشرفته دفاعی وزارت دفاع آمریکا (Darpa) میلیونها دلار بودجه برای پژوهش در مورد راههای تشخیص دیپ فیک اختصاص داده است. این مرکز تحقیقاتی تنها نیست؛ فیس بوک و گوگل هم برای رسیدن به متدهایی که چنین محتوایی را از اصل تشخیص و تمییز دهد، هزینه میکنند.

آژانسهای خبری مانند رویترز از همین حالا برای مبارزه و تشخیص دیپفیکها خودشان را مجهز میکنند. رویترز با تنظیم “فکتنچکر” سعی میکند خود را مجهز کند. اما مسئول بخش یوجی سی و راستآزمایی یوجی سی رویترز میگوید، دیپ فیکهای بسیار خوب حتی حرفهای ها را هم به اشتباه میاندازند.

دیدگاهتان را بنویسید

برای نوشتن دیدگاه باید وارد بشوید.